Mit Blick auf Südkorea wird in den Medien von Journalisten, Epidemiologen und Politikern seit Wochen eine „Tracing-App“ forciert, die sich Leute auf ihren Smartphones installieren…

Einen Kommentar hinterlassenKategorie: Software

Beginnen wir mal mit einem sehr einfachen Bild: Niemand braucht hunderte Arten von z.B. Supermarkt-Schokolade und Convenience-Lebensmitteln, trotzdem sind die Läden voll damit, verdrängen oft…

Einen Kommentar hinterlassenIch möchte hier mal meine Einschätzung für die nächsten 10 Jahre unserer Branche abgeben, vielleicht liege ich richtig? In den 2010er Jahren haben wir den…

Einen Kommentar hinterlassenRGB LED-Panels sind omnipräsent im Werbebereich, jedes Fussballstadion ist mit tausenden Panels vollgepflastert so wie auch viele Städte rund um den Globus mit Leuchtreklamen auf…

Einen Kommentar hinterlassenIn den letzten Tagen habe ich mich beruflich und privat wieder mit IT-Sicherheit beschäftigt. Hierbei habe ich privat nach offenen ElasticSearch- und Kibana-Instanzen sowie banalen Netzwerk-Druckern gesucht. Dabei habe ich mich auf die Datenbank Shodan verlassen und nicht selbst aktiv gescannt.

Das Ergebnis war insofern frustrierend, weil ich doch einige offene und fehlkonfigurierte Systeme fand. Manche offenbarten keine vertraulichen Daten, aber dafür den kompletten, maschinenlesbaren Katalog ihrer Produkte. Andere erfassten auch sämtliche Kundenattribute wie Anschrift, Handynummern, Geburtsdaten in ElasticSearch – entweder weil ElasticSearch als Suchmaschine eingesetzt wird oder im Rahmen einer Log-Aggregierung (z.B. mit Logstash und dem Frontend Kibana).

Ich habe alle betroffenen Unternehmen informiert (darunter auch ein großes, altes, renomiertes Schweizer Informatik-Unternehmen, das für seine insbesondere bei Kulturbetrieben in Frankreich verbreitete Ticketing-Anwendung Kundendaten im Rahmen eines Logs der Bonitätsabfrage „veröffentlicht“ – immerhin Klarnamen und Geburtsdaten)

Einen Kommentar hinterlassenJenkins CI wird noch immer in vielen größeren Organisationen für alle mögliche Dinge eingesetzt und obwohl das immer wieder sehr oft in Tränen endet, werden Erfahrungen und Ratschläge anderer ignoriert. Damit nicht noch mehr Tränen vergossen werden, schreibe ich das jetzt hier mal für alle auf: Lernt gratis aus den Schmerzen anderer und vermeidet diese Probleme mit der einfachen Lektüre dieses Blogposts!

Muss es überhaupt Jenkins sein?

Jenkins war das erste Mainstream CI-Tool und ist bis heute mit großem Abstand das populärste Tool im In-House-Einsatz, also on-premise oder der selbst verwalteten Cloud. Es stammt aus der Hochzeit der JEE-Webanwendungen und ist dementsprechend komplex und voller Legacy-Code. Besonders erwähnenswerte No-Gos für den Einsatz in 2019 sind meiner Meinung nach:

Einen Kommentar hinterlassenVor 2 1/2 Jahren stellte Chef.io ein neues Projekt namens „Habitat“ vor und bis vor kurzem sah ich keinen Grund, dieses Projekt einzusetzen. Ich hielt es für überflüssig, da der Markt schon lange entschieden hätte, auf Container zu setzen und dementsprechend die Lösungen gewinnen werden, die sich um die (damaligen) Anführer der Bewegung drehten bzw. von diesen empfohlen oder entwickelt werden.

Also Docker, dazu Swarm. Alternativ Rancher, eventuell CoreOS. Und Kubernetes.

Wie es bisher ausging, ist bekannt: CoreOS und rkt sind tot, ebenso wie Docker Swarm. Der Swarm-Mode dümpelt noch im Docker-EE-Segment herum, ansonsten setzt Gott und die Welt auf Kubernetes.

Doch eine Sache ist bis heute nicht signifikant vorangekommen, nämlich das Bauen von Container-Images. Docker’s Buildkit hat zwar jüngst mal wieder ein paar nette experimentelle Features geliefert, wie z.B. ssh-agent zur Build-Zeit. Doch die grundlegende Dockerfile-Syntax wurde beibehalten und so richtig gute Alternativen gibt es nicht.

Einen Kommentar hinterlassen

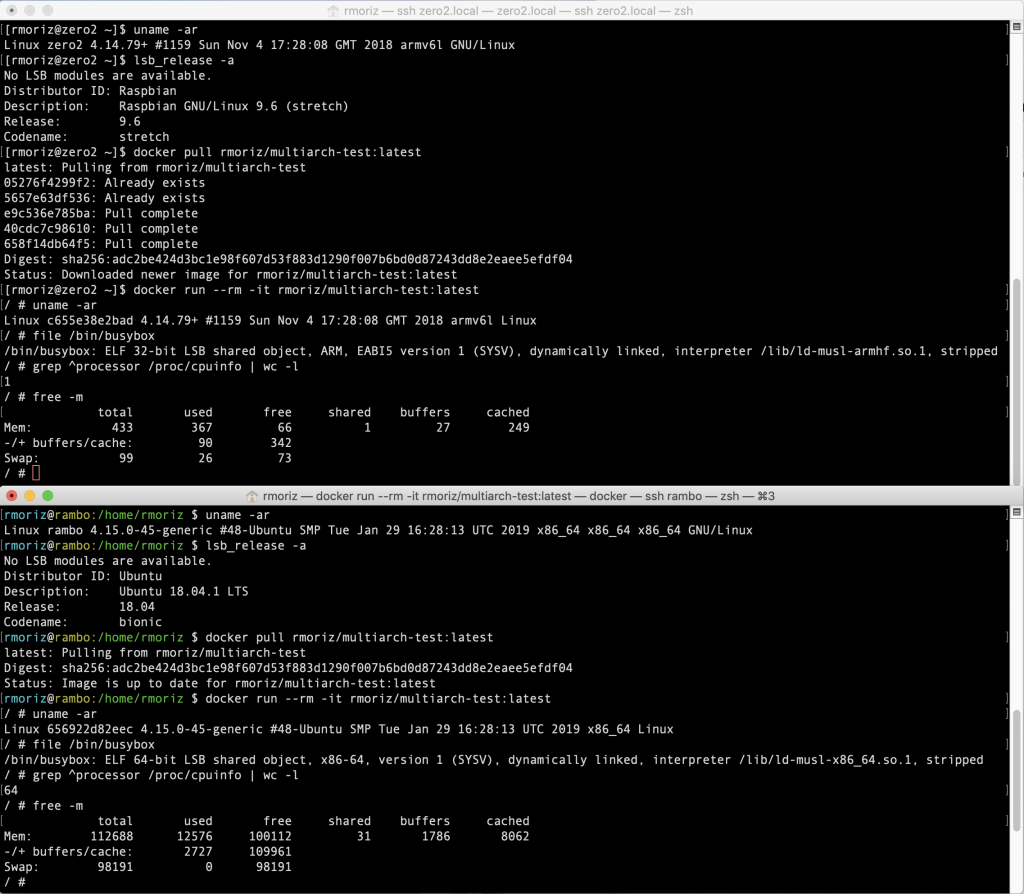

Unten: „Rambo“, 2 Xeon Prozessoren, 32 Kerne (64 mit Hyperthreading), 128GB RAM, >2500€

Die auf GitHub populären Frameworks und Sprachen der letzten 5 Jahre sind allesamt von Konzernen gelenkte Entwicklungen, die die Zukunft dieser Konzerne sichern und gegen disruptive Konkurrenten schützen soll.

Waren proprietäre Sprachen und Frameworks schon immer in allen Bereichen der Branchen präsent und verbreitet, so war dies fast immer auf Teilbereiche beschränkt: .Net auf Windows, Java für Enterprise-Anwendungen, Objective C für Macintosh. Dominierende OpenSource-Projekte der 1990er und 00er Jahre wie Perl, PHP, Python und Ruby waren allesamt „wirkliche“ OpenSource-Projekte einzelner Menschen und Unternehmen, ohne dass dort zwangsläufig eine absolute Dominanz ersichtlich war. Das lag natürlich auch an der auf (zugegeben sehr große) Teilbereiche der Software-Entwicklung. Wer Entscheidungen von Zend, der „PHP Company“ nicht mittragen wollte, hatte ausreichend Alternativen ohne nennenswerte Nachteile.

2 KommentareSeit einigen Jahren gibt es ein OpenSource-Remake des populären C&C Red Alert-Games. Unter OpenRA.net ist das Spiel für alle möglichen Plattformen (Linux, macOS, Windows) gratis zum Download verfügbar. Neben RA wurden auch Dune 2000 und Tiberian Dawn als Mods implementiert und können auf öffentlichen Servern (ohne Registrierung) gegeneinander gespielt werden.

Neben des C&C-Gameplays und liebevoller 90er-Jahre Grafik ist auch der Teamchat genau auf dem Niveau der vergangenen Zeit: Politisch unkorrekt und teilweise auch aggressiv trollt und spielt man, wie in alten Zeiten. Erfahrene Spieler tarnen sich als Newbies, Newbies ruinieren Multiplayer-Matches… lautstarke Trump-Trolle trollen andere lautstarke Trump-Trolle. So wie das Leben eben spielt.

Einen Kommentar hinterlassenAccess-Provider der westlichen Welt plagen ähnliche wirtschaftlichen Problem beim Thema Breitband: Einerseits sind hohe IP-Access-Bandbreiten erwünscht, andererseits ist der Ausbau teuer und deshalb wirtschaftlich selten darstellbar. Und dann wollen die Leute nicht nur zuhause sondern auch unterwegs hohe Bandbreiten nutzen und Investitionen in die Mobilfunknetze müssen in relativ kurzen Abständen wieder verdient werden, denn sie verlieren rasch an Wert.

Parallel verlegt man aufwendig Lichtwellenleiter (Glasfaser) immer näher zum Kunden (VDSL, Vectoring, FTTC) oder gleich ins Haus/Wohnung (FTTB/FTTH). Trotzdem gibt es in jedem „Vorzeigeland“ Regionen, in denen das auf absehbare Zeit nicht passieren wird. Sogar in der Schweiz, in Frankreich und in den Niederlanden.

Schon vor Jahren kam man deshalb auf die Idee, die verfügbaren Zugangswege (also Festnetz und Mobilfunk) zu bündeln und dadurch Kunden in diesen Regionen gesteigerte Bandbreiten anzubieten. Leider ist das nicht so einfach, wenn zwei oder mehr Transportwege sich in vielen Parametern unterscheiden (Latenz, Bandbreite, Nutzungsspitzen, Zuverlässigkeit).

In Deutschland gibt das Unternehmen Viprinet, dass eine proprietäre, closed-source Lösung mit eigener Hardware verkauft und damit seit Jahren auf Unternehmenskunden zielt. Die Telekom hat seit ein paar Jahren eine technisch eher schwache Lösung (auf GRE-Basis) am Start, die – soweit ich mich erinnere – von Huawei entwickelt wurde.

Wohingegen an der katholischen Universität in Löwen (Louvain) in Belgien seit über 10 Jahren an einem offenen Standard und offenen Implementierung gearbeitet wird. Der führende Entwickler ist seit Jahren bei Apple tätig und hat dort das von ihm mitentwickelte MPTCP (multipath TCP) in iOS implementiert. Siri als Anwendung setzt beispielsweise seit iOS 7 darauf um dynamisch WiFi und 4G zu bündeln.

Einen Kommentar hinterlassenWireGuard, mein absolutes Lieblings-VPN, hat eine einzige Schwäche für bestimmte Anwendungen: UDP darf nicht gefiltert bzw. blockiert werden. Das ist bei uns vermutlich kein Problem,…

Einen Kommentar hinterlassenWährend deutsche Politiker aller Parteien, Journalisten und viele Bürger laufend und mit größter Motivation ihre Unkenntnis und Unfähigkeit hinsichtlich IT und IT-Sicherheit zur Schau stellen, setzt sich in den USA bereits ein Senator dafür ein, dass die öffentliche Verwaltung die bisher eingesetzten, als komplex und veraltet geltenden VPN-Lösungen IPSec und OpenVPN durch WireGuard ersetzen soll.

Senator Ron Wyden (D) aus Oregon ist bereits 69 Jahre alt und hat sich in der Vergangenheit auch schon kritisch über die Aktivitäten von ZTE/China und das Thema Wahlbeeinflussung durch Hacks geäussert.

Seine Bitte an das NIST, das National Institute of Standards and Technology, WireGuard als Option für den Regierungs- und Verwaltungseinsatz zu evaluieren, kann man sich hier ansehen. (PDF Original)

1 KommentarNachdem selbst mein Raspberry PI Zero W knapp zwei Tage inkl. WireGuard durchlief (mit PersistentKeepalive-Option) und auch mein Macbook Air „versehentlich“ drei Tage unbemerkt via…

2 KommentareWer tcpdump verwendet, wird sich täglich über die Ausgabe „(oui Unknown)“ ärgern. Hierbei geht es um den „organizationally unique identifier“ einer MAC-Adresse, also den Hersteller des Gerätes bzw. Interfaces. Die Zuordnung eines Präfixes und Verwaltung dieser laufend wachsenden Liste unterliegt der IEEE und ist mit Gebühren verbunden.

Das Abrufen der gesamten Liste ist noch gratis…

… doch leider hat die IEEE die Adresse der Liste geändert (vermutlich schon in 2015), sodass sämtliche Bordmittel verbreiteter Linux-Systeme zur Aktualisierung nicht mehr funktionieren, beispielsweise das Aktualisierungs-Script des „ieee-data“ Packages in Debian, das zudem der motivierte Debian-Betreuer des „aircrack-ng“ Paketes auch statt der lange aktualisierten upstream-Version von „airodump-ng-oui-update“ einsetzt…

Einen Kommentar hinterlassenWäre ich Ermittler beim Brandenburger LKA, ich hätte mir 100 Raspberry PIs besorgt, darauf Kismet installiert, diese mit Powerbanks quer über das Land verteilt (oder fliegend in Polizeifahrzeuge verbaut) und würde mir sämtliche Daten in der Cloud sammeln und auswerten. Der Aufwand hierfür liegt im niedrigen fünfstelligen Bereich, mit 3G/4G Upstream etwas höher.

Einen Kommentar hinterlassenWer den Schaden hat, braucht für den Spott nicht zu sorgen. Oder wie es beim Fussball üblich ist: Der gefoulte schiesst nicht selbst den Elfmeter.

Robert Habeck wurde, wie einige andere Politiker und Social-Media-Leute, Opfer einer Cracker-Attacke. Vermutlich eine Person hat sich Zugang zu diversen Accounts beschafft, ob Social Media (Twitter/Facebook), Mail oder Cloud-Speicher. Soweit man weiss, haben die Betroffenen dort weder verfügbare 2-Faktor-Authentisierungen genutzt, noch sonstige Vorkehrungen getroffen, um solche Attacken durch Selbstschutz zu verhindern (sichere, lange, einfach genutzte Passwörter – zB mittels Passwortmanager).

Nun sind also persönliche Daten und teilweise auch Dinge aus dem familiären Umkreis veröffentlicht worden und die Betroffenen leiden, gut nachvollziehbar, unter einem Trauma (ähnlich Einbruchs- oder Überfallsopfer).

Es macht die Sache auch nicht besser, dass selbsternannte Netzpolitiker wie Konstantin von Notz (Grüne) zu den stark betroffen gehören, wo man doch vielleicht gerade von ihnen etwas mehr Sorgfalt im digitalen Alltag erwarten hätte können?

1 Kommentar(RTL steht für den verwendeten Chipsatz RTL2832U (und weitere), SDR steht für „Software Defined Radio“, also ein per Software gesteuertes/implementiertes Radio, d.h. der Hardware-Tuner liefert nur Rohsignale, die Demodulation/Verarbeitung erfolgt ausschliesslich in Software. Die „Entdeckung“ der Zweitnutzung handelsüblicher DVB-T USB-Empfänger hierfür geht u.A. auf das Osmocom Projekt zurück)

Nach ersten Versuchen mit einem „billigen“ (ca 15€) China-Restposten-DVB-T USB-Stick mit R820T Tuner habe ich etwas Geld in die Hand genommen und mir über Amazon.de den NooElec NESDR SMArTee XTR inkl. Zubehör besorgt.

Der dort verbaute E4000 Tuner kann noch ein etwas breiteres Spektrum inkl. ~1800 MHz empfangen, als die sonst üblichen R820T/T2 Tuner, allerdings mit einem „Loch“ im Bereich von ADS-B, ist dafür also nicht geeignet. Im Lieferumfang sind ein Magnetfuss und drei Antennen-Aufsätze enthalten.

Während ich mit dem bisherigen „Billo“ RTL2832U R820T im „alten“ 900MHz-GSM-Frequenzbereich gerade mal 2 Base Stations empfangen konnte, schaffe ich mit dem Nooelec (Link zum Hersteller) deutlich mehr:

2 KommentareIch arbeite oft von zuhause und empfange regelmäßig Pakete. Aber es nerven auch laufend Werbemüllverteiler am Klingelschalter. Blöderweise befindet sich mein Home-Office im Untergeschoss ohne Zugang zur Wechselsprechanlage oder Tür-Öffnungsknopf. Selbst wenn ich mit etwas Bastelei an der Siedle-Sprechanlage den Öffnungsimpuls noch per WiFi absenden könnte, so muss ich dann doch die Wendeltreppe hinauf zur Wohnungstüre und dort nachschauen, ob es für mich oder den Mülleimer geklingelt hat.

Nun leben wir in Zeiten, wo sich alle Menschen unbewusst überwachen lassen und das sogar passiv. Schienen RFID-Attacken auf Personalausweise, Gesundheitskarten oder vom Hersteller in Textilien eingenähten Tags mit großen Antennen etwas weit hergeholt, geht es mit Funkverbindungen sehr viel einfacher:

Jeder von uns trägt ein Smartphone oder eine Smartwatch bei sich, manche sogar mehrere. Die Smartphones buchen sich in Mobilfunknetze ein und halten ständig Kontakt zum nächsten Sendemast, senden regelmäßig Datenpakete um den jeweils am besten zu erreichenden zu ermitteln.

Und genau das tun auch alle WiFi-Clients: Sie senden regelmäßig Anfragen um für sie bekannte WLAN-Netze zu ermitteln und dann ggf. automatisch zu verbinden.

Beides lässt sich passiv mitschneiden und auswerten.

2 KommentareIn den USA wird ein Thema gerade groß: Patreon, eine Community-Plattform zur Einsammlung und Verteilung von „Spenden“ für Aktivisten, Blogger, Websitebetreiber und Contentproduzenten aller Art hat diversen Leuten den Account geschlossen und Gelder einbehalten. Angeblich auf Druck eines der großen Kreditkarten-Anbieter.

Gerade im libertär-konservativen Bereich beginnt man zu erkennen, dass hier nicht nur alt-right-Nazis „ohne Prozess“ ausgeschlossen werden, sondern eben dieses Mal auch Leute aus dem „normalen“ Spektrum. Sexworker, welche üblicherweise eher links verortet sind, haben schon vor Jahren ihre Accounts bei PayPal verloren und waren vor einigen Monaten auch bei Patreon wieder auf der Abschussliste, wieder sollen die Kreditkarten-Betreiber auf Basis ihrer Risk-Management-Policy eingeschritten sein.

Auch bei uns erkennt man die Macht der Kreditkartenunternehmen: So fallen z.B. fürs Lotto-Spiel zusätzliche Gebühren an in saftigen Höhen: 5€ pro Vorgang! Nun wird man das wohl mit „gestiegenem regulatorischen Aufwand und Zahlungsausfallrisiken“ begründen, ist aber letztlich nichts anderes, als eine Diskriminierung. So wie Facebook und Instagram pauschal blanke Nippel bestrafen, weil manche Teile der USA oder restlichen Welt damit nicht umgehen können, so wird der Zahlungsverkehrs-Filter nun global ausgerollt.

2 KommentareFalls auch jemand anderes 2019 dieses Vorhaben (wieder) aufgreifen möchte: Hypriot als Debian-Derivat scheint seit April 2018 unmaintained zu sein und den Wechsel von Debian…

Einen Kommentar hinterlassenHadmut Danisch ist ein streitbarer Informatiker und Blogger. Seine Sichtweisen bezüglich Informatik und Informatik in Deutschland teile ich zum allergrößten Teil, so wie jüngst in seinem Blogpost „Linux stirbt“.

Die von ihm oft ausgemachten Gründe der „Verweichlichung“, „Diversifikation“ oder „Quoten“ teile ich jedoch meistens nicht, auch in dem besagten Blogpost.

„Linux stirbt“ nicht wegen Linus, wegen eines Spendenaufrufes für Diversifikation oder einer Anti-Harassment-Policy, sonder aus einem anderen Grund: Zwar sieht es so aus, als ob die „privileged white men“ die überwiegend die letzten 27 Jahre am Kernel und viele Userland-Projekten tätig waren, die Ursache des Erfolges sind und jeder Versuch einer Diversifikation hier Projektsabotage sei. Doch wird hier vergessen, dass Linux damals relativ alternativlos war, sehr viele Leute in der Branche sehr viel Geld in sehr kurzer Zeit verdient und auch wieder in solche Projekte reinvestiert haben oder dadurch „Zeit spenden konnten“.

Einen Kommentar hinterlassenYouTube begann vor einiger Zeit damit, technisch auch Live-Streams zu ermöglichen. Die Technik dahinter ist relativer Standard, es kommt HLS (HTTP Live Streaming) und mpeg4 zum Einsatz. Das ganze wird über eine `.m3u`-Ressource abgewickelt, die der Browser abruft.

Nun möchte YouTube aber nicht, dass man auf bestimmten Geräten den Stream im Hintergrund laufen lässt, oder sogar Videos generell: Vermutlich um den „Missbrauch“ als Gratis-Spotify zu verhindern und den Video-Werbenden auch „Video“-Werbung verkaufen zu können.

Mir sind die wirtschaftlichen Hintergründe und die YouTube AGB egal, weil YouTube als Teil von Alphabet auch ein Monopolist ist und Live-Streaming eines der wenigen Bereiche ist, bei dem sie nicht den Markt dominieren (Amazons Twitch ist hier dominierend).

Nun schaue ich gerne diverse regelmäßige Livestreams an, u.a. die Mainboad-Repair-Videos von Louis Rossmann aus New York oder die langen Streams von Bjørn Nyland aus Oslo, wenn er mit einem Elektroauto tausende Kilometer durch Norwegen zurücklegt. Diese Art von Streams sind unerhaltsam, aber einfach nicht ausfüllend genug, um sie 100% der Zeit „modal“ zu konsumieren und so laufen die Streams bei mir im Hintergrund – leider bisher nicht auf iOS oder Android-Geräten, weil YouTube dies unterbindet.

Und dann gibt es noch Streams, die von den Produzenten wieder gelöscht werden, weil etwas zu skurriles oder unprofessionelles passiert ist: Das frisierte E-Bike fackelt mitten in Manhattan ab,oder ein Idiot darf sich wegen unprofessioneller Fahrweise einen lauten Anschiss anhören. All das will man als Fan natürlich mitbekommen, auch wenn man gerade nicht in der passenden Zeitzone lebt oder anderweitig beschäftigt war.

Eine Archivierungs-Lösung muss her!

Einen Kommentar hinterlassenMit dem macOS 10.14 Release hat Apple das Sub-Pixel-Rendering für alte non-Retina Macbooks entfernt, mein mittlerweile fast nur noch privat genutztes 11″ Macbook Air (Early 2015) war davon auch betroffen. Mit der Zeit stellten sich zudem recht ungewöhnliche Verschleisserscheinungen ein, z.B. hat sich hier zum ersten Mal in meiner jetzt über zwölfjährigen Macbook-Zeit ein Teil einer Tastenbeschriftung verabschiedet (A-Taste) und man merkt jetzt such schon das Altern des Akkus.

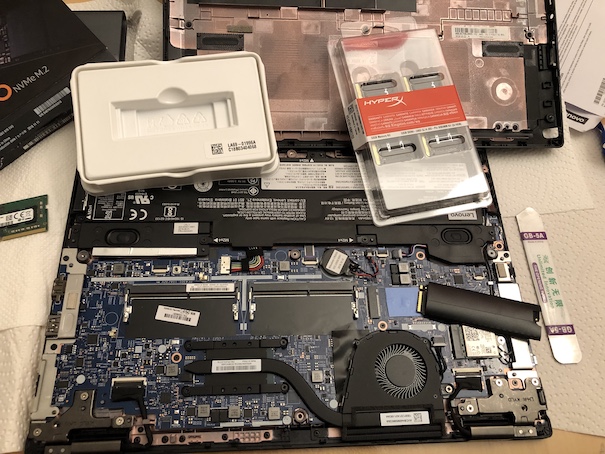

Etwas neues musste her, weil ich auch beruflich ein Linux-Device für die aktuellen Aufgaben benötige (InfoSec + Containerkram + DevOps) und so fiel die Wahl am Black Friday auf ein Lenovo Thinkpad L380 Yoga (13″ convertible mit FHD-Display), welches zufälligerweise unter der mittlerweile erhöhten Abschreibungsgrenze von 810€ netto direkt von Lenovo zu haben war.

Bisher bin ich mit dem Gerät sehr zufrieden, es erfüllt alle Erwartungen und ist ganz gut verarbeitet. Selbst ein Hardware-Maintenance-Manual ist frei zugänglich, um Komponenten auszutauschen oder zu erweitern: Es würden bis zu 32 GB Arbeitsspeicher reinpassen oder eben eine M.2 2280 PCIe-SSD nach Wahl. Und das bei einem Gerät für um die 900€ brutto inkl. Versand, Netzteil.

Nichts veränderte sich in den letzten Jahre so schnell und radikal wie der Bereich Webentwicklung. Zuerst Perl, dann PHP, dann etwas Ruby, heute JavaScript. Jedem Technologiesprung wurden diverse Gründe nachgesagt und in vielen Fällen war auch relativ schnell erkennbar, dass sich die neuen Tools im Einsatz auszahlen: Schnellere, bessere Entwicklung, optimierte Betriebskosten. Gerade der Hype um Ruby on Rails war auch sehr stark von Entrepreneurship geprägt, also dem Gründergeist ein wirtschaftlich tragbares Unternehmen aus eigenen Kräften aufzubauen, so wie es der „Erfinder“ DHH tat.

Der Schritt zu JavaScript im Frontend wurde hingegen mit nicht schlüssigen Begründungen gepusht: Alles asynchron, schnellere Ladezeiten, „eine Sprache für alles“, mehr Traffic mit weniger Hardware erreichbar – alles nicht wirklich messbar oder für die wenigstens Unternehmen relevant, ausser man hat die Größe von Google oder Facebook. Der mit dem Wechsel im Frontend einhergehende Wechsel im Nutzerverhalten in Richtung Mobiltelefone und Tablets inklusive diverse Appstores („Walled Gardens“) hat die wirtschaftliche Bedeutung des Webs als Plattform aber gleichzeitig sinken lassen:

Einen Kommentar hinterlassen